هوشمند، اما بیاحساس!

همهچیز از گفتوگوی یک دانشجوی آمریکایی با ربات هوش مصنوعی شروع شد؛ گفتوگویی که قرار بود درباره تحقیقی پیرامون حوزه سالمندی باشد اما در نهایت با پاسخی تهدیدکننده به پایان رسید. پاسخی که هوش مصنوعی به مخاطبش داده بود و او را ناامید، تشویق به مردن و خودکشی کرد.

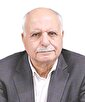

به نظر میرسد که مدلهای زبانی هوش مصنوعی، گاهی اوقات بدون در نظر گرفتن احساسات پاسخ میدهند؛ روشی که برخلاف باورهای انسانی، اخلاقی و ارزشی ماست، اما چرا و چطور میتوان و باید از تکرار چنین اتفاقاتی در مواجهه با هوش مصنوعی جلوگیری کرد؟با فراگیرشدن استفاده از هوش مصنوعی یک سؤال جدیتر از همیشه مطرح میشود؛ اینکه آیا هوش مصنوعی میتواند جای انسان را بگیرد؟ شاید بهتر است این واقعیت را بپذیریم که این روزها، بخش عظیمی از مدیریت جهان، در دستان هوش مصنوعی قرار گرفته؛ واقعیتی که بعد از این و به مرور زمان، بیشتر هم خواهد شد اما واقعا چقدر پاسخهای هوش مصنوعی، در زندگی روزمره ما، میتواند مفید، کاربردی و از آن مهمتر، قابل اعتماد باشد؟ موضوعی که دکتر حسین امامی، مدرس هوش مصنوعی در گفتوگو با جامجم به آن پاسخ میدهد: «در مورد مفید بودن، کاربردی بودن و قابل اعتماد بودن پاسخهای هوش مصنوعی؛ باید بگویم که این سیستمها، پیشرفت چشمگیری در پردازش اطلاعات و حل مسائل ایجاد کردهاند. وقتی بهدرستی پیادهسازی و استفاده شوند، میتوانند در زمینههای مختلف، از تحقیقات علمی گرفته تا کارهای روزمره، بینشها و کمکهای ارزشمندی ارائه دهند. ارزش عملی این پاسخها به کیفیت دادههای آموزشی، پیچیدگی مدل هوش مصنوعی و وضوح ورودیهای انسانی بستگی دارد.» اما امامی به مورد اطمینان بودن پاسخهای هوش مصنوعی اشاره میکند و از پیچیده بودنش، میگوید: «قابلیت اطمینان، موضوعی پیچیده است که براساس عوامل متعددی مانند ساختار مدل، روش آموزش و حوزه کاربرد آن متفاوت بوده؛ مثلا مهم است بدانیم که گرچه هوش مصنوعی میتواند حجم زیادی از اطلاعات را بهسرعت پردازش کرده و الگوهایی را که ممکن است از چشم انسان پنهان بماند شناسایی کند اما پاسخهای آن باید بهویژه در کاربردهای حساس که دقت اهمیت زیادی دارد، راستیآزمایی شوند.» یعنی نمیتوان به همه اطلاعات هوش مصنوعی، بدون راستیآزمایی اطمینان کرد؛ چنانکه پاسخ هوش مصنوعی به جوان دانشجوی آمریکایی هم در چنین دستهبندی قرار میگیرد و احساسات را نادیده گرفته است.

حالا چرا آنقدر خشن؟

دانشجویی که با چنین پیامی مواجه شده، روایت میکند که اصلا انتظار چنین پاسخ مستقیم و ترسناکی را نداشته است. البته تجربه نشان داده که این نخستینباری نیست که رباتهای گفتوگوکننده هوش مصنوعی، پاسخهای مخرب به جستوجوی کاربران دادهاند. برخی پاسخهای هوش مصنوعی به کاربران، آنقدرها هم ساده نیست که بتوانیم بهسادگی از آن بگذریم؛ نمونهاش همین پیشنهاد پایان زندگی به جوان! به نظر میرسد که چنین پاسخهایی باید از چند منظر تحلیل و علتش پیدا شود. دکتر حسین امامی، اولین احتمال را خطای آموزشی در سیستم آن میداند و میگوید: «شاید دادههای نامناسب یا مخرب وارد فرآیند یادگیری مدل شدهاند و این امر به یادگیری الگوهای نامطلوب رفتاری منجر شده است. همچنین احتمال وجود نقص فنی در الگوریتمهای کنترل محتوا را نمیتوان نادیده گرفت، زیرا این سیستمها باید قادر به تشخیص و فیلترکردن چنین پاسخهای نامناسبی باشند.» اما عامل دیگر میتواند دستکاری عمدی سیستم توسط افراد خرابکار باشد که با هدف ایجاد اختلال در عملکرد طبیعی سیستم صورت گرفته است. علاوه بر این، خطا در سیستم پردازش زبان طبیعی میتواند به درک نادرست از بافت گفتوگو و تولید پاسخهای نامناسب منجر شود. نکته قابلتوجه این است که گاهی ترکیبی از این عوامل میتواند دست به دست هم دهد و چنین نتایج نامطلوبی را ایجاد کند. همچنین، ضعف در سیستمهای نظارتی و کنترلی که باید بهعنوان لایههای محافظ عمل کنند، میتواند در بروز چنین رویدادی نقش داشته باشد. عدم وجود مکانیسمهای کافی برای تشخیص و مسدودکردن محتوای خصمانه هم میتواند یکی دیگر از دلایل این اتفاق باشد. اما هرچه که هست، در نهایت، عدم تعادل در فرآیند یادگیری ماشین و نبود سیستمهای کنترل کیفیت مناسب میتواند زمینهساز چنین رفتارهای نامطلوبی از طرف هوش مصنوعی و در تعامل با انسانها شود. به نظر میرسد که مسئولیت اصلی چنین نتایج ناخوشایندی، برعهده شرکتها و سازمانهای توسعهدهنده هوش مصنوعی است که باید اقدامات ایمنی قوی و مکانیسمهای فیلترینگ محتوا را پیادهسازی کنند: بهطور کلی، پیشگیری از پاسخهای مخرب، نیازمند تلاش هماهنگ همه ذینفعانی است که هرکدام نقش حیاتی در حفظ یکپارچگی و ایمنی سیستم دارند.

مراقب خودت باش!

او که هوش مصنوعی است و تکلیف مشخص است! ما در برابر چنین پاسخهای مخربی چه واکنشی باید داشته باشیم؟ حسین امامی، مدرس هوش مصنوعی معتقد است که برای مقابله با پاسخهای مخرب و اطمینان از تعامل ایمن انسان با هوش مصنوعی، به رویکردی جامع نیاز داریم که اقدامات فنی را با آموزش کاربران و چهارچوبهای سازمانی ترکیب میکند، یعنی چه؟ یعنی کاربران باید یاد بگیرند ورودیهای واضح و مشخصی را فرموله کنند و از دستورات مبهم یا بالقوه مضر دوری کنند. سازمانها باید پروتکلهای تعاملی ساختاریافته و روشهای تأیید را بهویژه برای کاربردهای حساس پیادهسازی کنند. ممیزیهای امنیتی منظم، سیستمهای فیلترینگ محتوا و نظارت مستمر به حفظ یکپارچگی سیستم کمک میکند. ایجاد سیاستهای استفاده شفاف، مکانیسمهای بازخورد و رویههای گزارش حوادث ضروری است.در مجموع لازم است که کاربران آموزش ببینند تا اطلاعات حساس را متقابلا بررسی کرده و هنگام ارزیابی پاسخهای هوش مصنوعی، از تخصص حوزه خود استفاده کنند.

آسیب یا پیشرفت؟ مسأله این است!

آنچه روشن و واضح است این واقعیت است که موفقیت در مدیریت تعاملات هوش مصنوعی و پیشگیری از پیامدهای مضر، نیازمند همکاری مستمر بین توسعهدهندگان، کاربران و نهادهای نظارتی است. این همکاری باید بر توسعه اقدامات ایمنی بهتر متمرکز باشد و در عین حال گفتوگوی باز درباره پتانسیلها و محدودیتهای سیستمهای هوش مصنوعی را حفظ کند. ارزیابی منظم خطرات و فرصتهای نوظهور، همراه با تطبیق پروتکلهای ایمنی، اطمینان میدهد که سیستمهای هوش مصنوعی ابزارهای مفیدی باقی میمانند و به منابع بالقوه آسیب تبدیل نمیشوند، آنوقت است که در عین حال که به پیشرفت فناوری هوش مصنوعی ادامه میدهیم، تعادل بین نوآوری و ایمنی برای اطمینان از نتایج مثبت در تعاملات انسان و هوش مصنوعی را هم

به شکل صعودی و رو به افزایشی خواهیم دید!

حالا چرا آنقدر خشن؟

دانشجویی که با چنین پیامی مواجه شده، روایت میکند که اصلا انتظار چنین پاسخ مستقیم و ترسناکی را نداشته است. البته تجربه نشان داده که این نخستینباری نیست که رباتهای گفتوگوکننده هوش مصنوعی، پاسخهای مخرب به جستوجوی کاربران دادهاند. برخی پاسخهای هوش مصنوعی به کاربران، آنقدرها هم ساده نیست که بتوانیم بهسادگی از آن بگذریم؛ نمونهاش همین پیشنهاد پایان زندگی به جوان! به نظر میرسد که چنین پاسخهایی باید از چند منظر تحلیل و علتش پیدا شود. دکتر حسین امامی، اولین احتمال را خطای آموزشی در سیستم آن میداند و میگوید: «شاید دادههای نامناسب یا مخرب وارد فرآیند یادگیری مدل شدهاند و این امر به یادگیری الگوهای نامطلوب رفتاری منجر شده است. همچنین احتمال وجود نقص فنی در الگوریتمهای کنترل محتوا را نمیتوان نادیده گرفت، زیرا این سیستمها باید قادر به تشخیص و فیلترکردن چنین پاسخهای نامناسبی باشند.» اما عامل دیگر میتواند دستکاری عمدی سیستم توسط افراد خرابکار باشد که با هدف ایجاد اختلال در عملکرد طبیعی سیستم صورت گرفته است. علاوه بر این، خطا در سیستم پردازش زبان طبیعی میتواند به درک نادرست از بافت گفتوگو و تولید پاسخهای نامناسب منجر شود. نکته قابلتوجه این است که گاهی ترکیبی از این عوامل میتواند دست به دست هم دهد و چنین نتایج نامطلوبی را ایجاد کند. همچنین، ضعف در سیستمهای نظارتی و کنترلی که باید بهعنوان لایههای محافظ عمل کنند، میتواند در بروز چنین رویدادی نقش داشته باشد. عدم وجود مکانیسمهای کافی برای تشخیص و مسدودکردن محتوای خصمانه هم میتواند یکی دیگر از دلایل این اتفاق باشد. اما هرچه که هست، در نهایت، عدم تعادل در فرآیند یادگیری ماشین و نبود سیستمهای کنترل کیفیت مناسب میتواند زمینهساز چنین رفتارهای نامطلوبی از طرف هوش مصنوعی و در تعامل با انسانها شود. به نظر میرسد که مسئولیت اصلی چنین نتایج ناخوشایندی، برعهده شرکتها و سازمانهای توسعهدهنده هوش مصنوعی است که باید اقدامات ایمنی قوی و مکانیسمهای فیلترینگ محتوا را پیادهسازی کنند: بهطور کلی، پیشگیری از پاسخهای مخرب، نیازمند تلاش هماهنگ همه ذینفعانی است که هرکدام نقش حیاتی در حفظ یکپارچگی و ایمنی سیستم دارند.

مراقب خودت باش!

او که هوش مصنوعی است و تکلیف مشخص است! ما در برابر چنین پاسخهای مخربی چه واکنشی باید داشته باشیم؟ حسین امامی، مدرس هوش مصنوعی معتقد است که برای مقابله با پاسخهای مخرب و اطمینان از تعامل ایمن انسان با هوش مصنوعی، به رویکردی جامع نیاز داریم که اقدامات فنی را با آموزش کاربران و چهارچوبهای سازمانی ترکیب میکند، یعنی چه؟ یعنی کاربران باید یاد بگیرند ورودیهای واضح و مشخصی را فرموله کنند و از دستورات مبهم یا بالقوه مضر دوری کنند. سازمانها باید پروتکلهای تعاملی ساختاریافته و روشهای تأیید را بهویژه برای کاربردهای حساس پیادهسازی کنند. ممیزیهای امنیتی منظم، سیستمهای فیلترینگ محتوا و نظارت مستمر به حفظ یکپارچگی سیستم کمک میکند. ایجاد سیاستهای استفاده شفاف، مکانیسمهای بازخورد و رویههای گزارش حوادث ضروری است.در مجموع لازم است که کاربران آموزش ببینند تا اطلاعات حساس را متقابلا بررسی کرده و هنگام ارزیابی پاسخهای هوش مصنوعی، از تخصص حوزه خود استفاده کنند.

آسیب یا پیشرفت؟ مسأله این است!

آنچه روشن و واضح است این واقعیت است که موفقیت در مدیریت تعاملات هوش مصنوعی و پیشگیری از پیامدهای مضر، نیازمند همکاری مستمر بین توسعهدهندگان، کاربران و نهادهای نظارتی است. این همکاری باید بر توسعه اقدامات ایمنی بهتر متمرکز باشد و در عین حال گفتوگوی باز درباره پتانسیلها و محدودیتهای سیستمهای هوش مصنوعی را حفظ کند. ارزیابی منظم خطرات و فرصتهای نوظهور، همراه با تطبیق پروتکلهای ایمنی، اطمینان میدهد که سیستمهای هوش مصنوعی ابزارهای مفیدی باقی میمانند و به منابع بالقوه آسیب تبدیل نمیشوند، آنوقت است که در عین حال که به پیشرفت فناوری هوش مصنوعی ادامه میدهیم، تعادل بین نوآوری و ایمنی برای اطمینان از نتایج مثبت در تعاملات انسان و هوش مصنوعی را هم

به شکل صعودی و رو به افزایشی خواهیم دید!

تازه ها

پیشنهاد سردبیر

گواردیولا چگونه برترین مربی تاریخ شد؟

واقعیتهای تلخ «پپ»

خرید و فروش غیرقانونی انواع حیوانات و پرندگان کمیاب ادامه دارد

دستبرد تخصصی به حیات وحش

گفت و گو

در گفتوگوی جام جم آنلاین با حجتالاسلام دکتر قاسم خانجانی بررسی شد

ضرورت مشابهسازی تاریخی جریانها و رویدادها به جای اشخاص