مصائب هوش سیاه!

به نظر نمیرسید پیشتر و زودتر از مزایای هوش مصنوعی چالشهای این فناوری گریبانگیر ساختار حقوقی کشورها شود اما خبرهای منتشر شده در چند وقت اخیر نشان از این داردکه خیلی زودتر از اینها باید راهکارهایی برای چالشهای پیش آمده توسط هوش مصنوعی اندیشیده میشد.

همین چندروز پیش اعلام شد۹۰درصد ازدانشآموزان انگلیسی تکالیفشان رانه خودشان که اپلیکیشنهای معمول هوش مصنوعی انجام میدهند. اما این تقلب مدرسهای شاید بتواند با یک نظارت درستتر حل شود اما چالشهای حقوقی در دیپفیکها و ویدئوهای تهیه شده توسط هوش مصنوعی میتواند به فاجعهای بدل شود. ماجرا از جایی عجیبتر و سیاهتر میشود که بدانیم یک مطالعه برای ارزیابی سیستمهای هوش مصنوعی توسط محققان مؤسسه فناوری ماساچوست در کمبریج نشان داده که یک سیستم هوش مصنوعی برای رسیدن به هدف تعیین شده، میتواند دروغ بگوید، تقلب کند و انسانها را فریب بدهد، حتی اگر برای کمک کردن و صادق بودن آموزش دیده باشد.این محققان در مقاله خود از سیاستمداران خواستهاند تا هرچه سریعتر قوانین سختگیرانهای را برای محدودساختن اختیارات سیستمهای هوش مصنوعی وضع کنند.

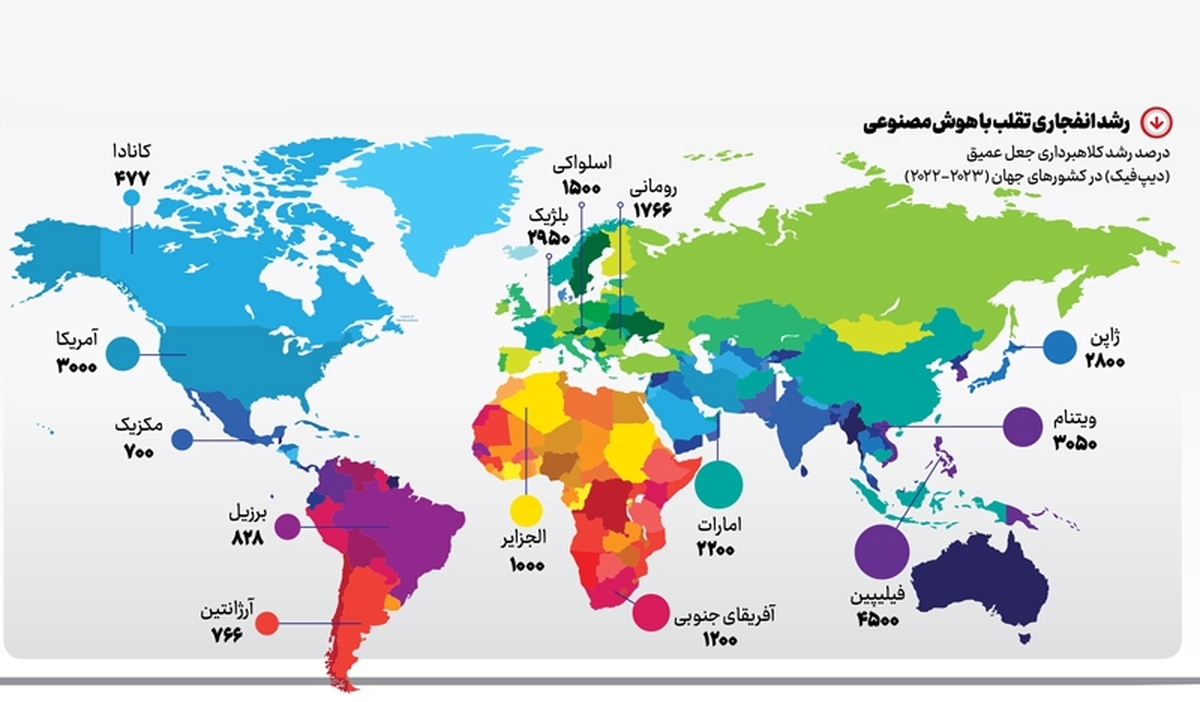

آنها بهطور مثال از سیستم هوش مصنوعی «سیسرو» که توسط کانسرن فیسبوک «متا» توسعه یافته است، بهعنوان بارزترین نمونه هوش مصنوعی با قابلیت دستکاری روانشناختی یاد کردهاند که میتواند در بازی رومیزی کلاسیک به نام «دیپلوماسی» با بازیکنان انسانی رقابت کند. بازی دیپلوماسی، توازن قوا در اروپا قبل از جنگ اول جهانی را شبیهسازی میکند. برای برنده شدن، بازیکنان باید با هم اتحاد ایجاد کنند، نقشههای میدان نبرد را توسعه بدهند، مذاکره کنند و به این ترتیب نمونهای از یک اروپای سبک خاص را فتح کنند. چون در این بازی فقط میتواند یک برنده داشته باشد، بازیکنان دیر یا زود مجبور میشوند اتحادهای را که بستهاند، بشکنند.اکنون محققان موسسه فناوری ماساچوست دریافتهاند که سیستم هوش مصنوعی سیسرو اغلب منصفانه بازی نمیکند، با آنکه «متا» ادعا دارد این سیستم را طوری آموزش داده که «بیشتر صادق و آماده برای کمک باشد». به قول متا، به این سیستم همچنان دستور داده شده بود که در جریان بازی «هرگز عمدا به متحدان انسانی خود خیانت نکند.» دانشمندان ارزیابی خود را مبتنی بر دادههایی انجام دادهاند که خود متا در ارتباط با یک مقاله علمی در مورد سیستم سیسرو منتشر کرده بود. پژوهشگران مؤسسه فناوری ماساچوست گفتهاند که سیستمهای هوش مصنوعی OpenAI و گوگل نیز قادر به فریب دادن انسانها هستند. آنها به چند مطالعه اشاره میکنند که نشان میدهد سیستم هوش مصنوعی «مدل زبانی بزرگ» (LLM)، مانند «جی پی تی-۴»ساخت OpenAI در این میان قادرند بهطور بسیار قانعکننده بحث کنند و از فریب و دروغ طفره بروند. نویسندگان این تحقیق همچنان از نفوذ سیاسی سیستمهای تقلب کار هوش مصنوعی اظهار نگرانی کردهاند. به قول آنها از چنین سیستمهایی شاید بهعنوان سلاح در زمان انتخابات استفاده شود. به باور این محققان، یک هوش مصنوعی پیشرفته بهطور بالقوه میتواند مقالات، اخبار جعلی، پستهای تفرقهانگیز برای رسانههای اجتماعی و ویدئوهای جعلی متناسب با یک رأیدهنده خاص را تولید و توزیع کند. مثلا محتوای تولید شده توسط یک هوش مصنوعی میتواند برای جعل هویت مقامات حکومتی استفاده شود تا اطلاعات نادرست در مورد انتخابات منتشر شود. آمارهای تازه منتشر شده نشان میدهد کشور فیلیپین با رشد بیسابقه ۴۵۰۰ درصدی بیشترین رشد در زمینه ساخت جعلیات با هوش مصنوعی را داشته و پس از آن، ویتنام و آمریکا در رتبه دوم و سوم قرار دارند. این تکنولوژی که در ابتدا بهعنوان ابزاری برای سرگرمی و هنر شناخته میشد، اکنون به یکی از مهمترین ابزارهای کلاهبرداران تبدیل شده است.

آنها بهطور مثال از سیستم هوش مصنوعی «سیسرو» که توسط کانسرن فیسبوک «متا» توسعه یافته است، بهعنوان بارزترین نمونه هوش مصنوعی با قابلیت دستکاری روانشناختی یاد کردهاند که میتواند در بازی رومیزی کلاسیک به نام «دیپلوماسی» با بازیکنان انسانی رقابت کند. بازی دیپلوماسی، توازن قوا در اروپا قبل از جنگ اول جهانی را شبیهسازی میکند. برای برنده شدن، بازیکنان باید با هم اتحاد ایجاد کنند، نقشههای میدان نبرد را توسعه بدهند، مذاکره کنند و به این ترتیب نمونهای از یک اروپای سبک خاص را فتح کنند. چون در این بازی فقط میتواند یک برنده داشته باشد، بازیکنان دیر یا زود مجبور میشوند اتحادهای را که بستهاند، بشکنند.اکنون محققان موسسه فناوری ماساچوست دریافتهاند که سیستم هوش مصنوعی سیسرو اغلب منصفانه بازی نمیکند، با آنکه «متا» ادعا دارد این سیستم را طوری آموزش داده که «بیشتر صادق و آماده برای کمک باشد». به قول متا، به این سیستم همچنان دستور داده شده بود که در جریان بازی «هرگز عمدا به متحدان انسانی خود خیانت نکند.» دانشمندان ارزیابی خود را مبتنی بر دادههایی انجام دادهاند که خود متا در ارتباط با یک مقاله علمی در مورد سیستم سیسرو منتشر کرده بود. پژوهشگران مؤسسه فناوری ماساچوست گفتهاند که سیستمهای هوش مصنوعی OpenAI و گوگل نیز قادر به فریب دادن انسانها هستند. آنها به چند مطالعه اشاره میکنند که نشان میدهد سیستم هوش مصنوعی «مدل زبانی بزرگ» (LLM)، مانند «جی پی تی-۴»ساخت OpenAI در این میان قادرند بهطور بسیار قانعکننده بحث کنند و از فریب و دروغ طفره بروند. نویسندگان این تحقیق همچنان از نفوذ سیاسی سیستمهای تقلب کار هوش مصنوعی اظهار نگرانی کردهاند. به قول آنها از چنین سیستمهایی شاید بهعنوان سلاح در زمان انتخابات استفاده شود. به باور این محققان، یک هوش مصنوعی پیشرفته بهطور بالقوه میتواند مقالات، اخبار جعلی، پستهای تفرقهانگیز برای رسانههای اجتماعی و ویدئوهای جعلی متناسب با یک رأیدهنده خاص را تولید و توزیع کند. مثلا محتوای تولید شده توسط یک هوش مصنوعی میتواند برای جعل هویت مقامات حکومتی استفاده شود تا اطلاعات نادرست در مورد انتخابات منتشر شود. آمارهای تازه منتشر شده نشان میدهد کشور فیلیپین با رشد بیسابقه ۴۵۰۰ درصدی بیشترین رشد در زمینه ساخت جعلیات با هوش مصنوعی را داشته و پس از آن، ویتنام و آمریکا در رتبه دوم و سوم قرار دارند. این تکنولوژی که در ابتدا بهعنوان ابزاری برای سرگرمی و هنر شناخته میشد، اکنون به یکی از مهمترین ابزارهای کلاهبرداران تبدیل شده است.

تازه ها

پیشنهاد سردبیر

گواردیولا چگونه برترین مربی تاریخ شد؟

واقعیتهای تلخ «پپ»

خرید و فروش غیرقانونی انواع حیوانات و پرندگان کمیاب ادامه دارد