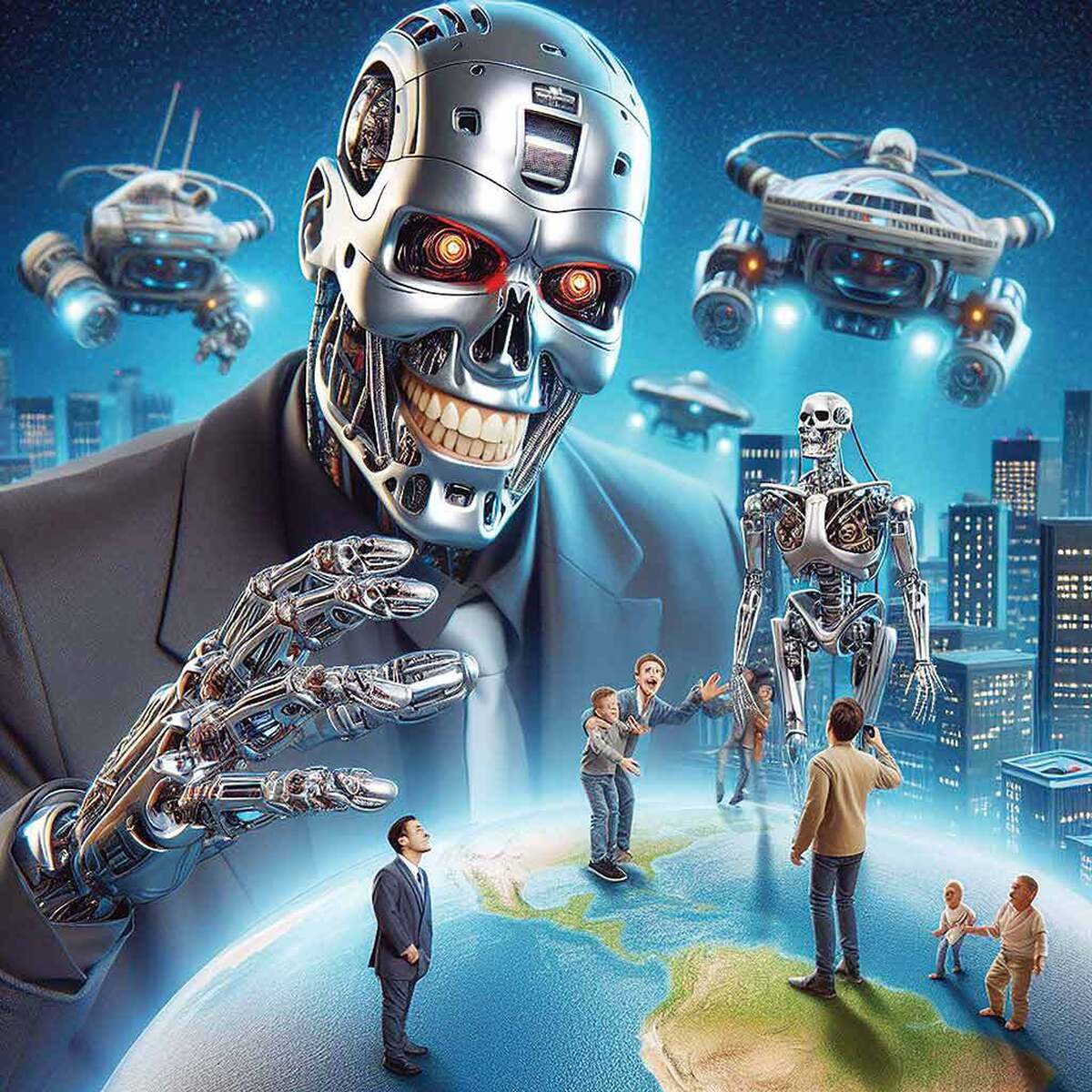

اما آنچه امروز میخواهیم درباره آن صحبت کنیم ریسکهایی است که دخالت دادن بیش از حد هوش مصنوعی در زندگی میتواند به فرد و حتی جامعه داشته باشد؛ آسیبهایی فراتر از تنبلی ذهن یا ته کشیدن خلاقیت در انسان که اسم آن را در کلیترین حالت خود ریسکهای مهندسی افکارعمومی میگذاریم و سعی داریم این خطرات را با مثالهای آشنایی از دنیای سینما که احتمالا آنها را پیش از این دیدهاید، بررسی کنیم.

پروپاگاندا به سبک هوش مصنوعی

الگوریتمهای هوش مصنوعی میتوانند بهسرعت و در مقیاسی غیرقابل تصور، محتوای جعلی (دیپفیک، متون دروغین، اخبار ساختگی) تولید و منتشر کنند. این الگوریتمها با تحلیل روانشناختی کاربران، این محتوا را به سمت افرادی هدایت میکنند که بیشترین آمادگی را برای پذیرش آن دارند و به این ترتیب باعث ایجاد تفرقه، بیاعتمادی و هدایت افکار عمومی در راستای اهداف خاص سیاسی یا تجاری میشوند. برای فهم بهتر این خطر بهتر است نیمنگاهی به مینیسریال بازداشت (Capture) داشته باشیم؛ این سریال به شکلی دقیق و هولناک نشان میدهد که چگونه میتوان با استفاده از فناوری دیپفیک (Deepfake) و دستکاری زنده تصاویر دوربینهای مداربسته، روایتی کاملا جعلی از یک رویداد ساخت و فردی را بیگناه یا گناهکار جلوه داد. این سریال عملا نشان میدهد که دیگر نمیتوان به چیزی که با چشمان خود میبینیم اعتماد کنیم و چگونه این فناوری میتواند برای دستکاری عدالت و افکار عمومی به کار رود.

حبابهای اطلاعاتی

یکی از حربههای قدیمی موتورهای جستوجو که الان نیز توسط هوش مصنوعی به کار گرفته میشود نشان دادن محتوا براساس فعالیتهای قبلی کاربر است. در این فرآیند که توسط هوش مصنوعی مدیریت میشود، بهتدریج کاربر را در یک «حباب» اطلاعاتی حبس کرده و از او دربرابر دیدگاههای مخالف محافظت میکند. این امر منجر به تقویت افراطیگری، کاهش همدلی و از بین رفتن گفتوگوی سازنده در جامعه میشود.اگریکی ازدنبالکنندگان سریال پرطرفدار آینه سیاه(Black Mirror) باشید، حتما به خاطر دارید که این سریال در اپیزود (Nosedive) جامعهای را به تصویر میکشد که در آن هر تعامل اجتماعی براساس یک سیستم امتیازدهی رتبهبندی میشود. الگوریتمها و فشارهای اجتماعی افراد را مجبور میکنند تا همواره نسخهای بینقص و مورد پسند دیگران از خود ارائه دهند. این امر یک اتاق پژواک یا حباب اطلاعاتی از مثبتاندیشی سمی ایجاد میکند و هرگونه رفتار خارج از هنجار را بهشدت سرکوب میکند.

دستکاری روانشناختی

یکی دیگر از خطرهایی که در استفاده افراطی از هوش مصنوعی در کمین کاربران قرار دارد، دستکاری روانشناختی است. هوش مصنوعی میتواند با تحلیل ردپاهای دیجیتال ما (لایکها، جستوجوها، خریدها و...)، پروفایلهای روانشناختی بسیار دقیقی از هر فرد ایجاد کند؛ سپس با استفاده از این پروفایلها، پیامهای تبلیغاتی یا سیاسی شخصیسازیشدهای ارسال میکند که دقیقا نقاطضعف، ترسها و امیدهای آن فرد را هدف قرار میدهد. این سطح از دستکاری، مرز میان متقاعدسازی و کنترل ذهن را بسیار باریک میکند. سال ۲۰۱۴ فیلمی درباره یک هوش مصنوعی به نام ایوا (اشاره مستقیم به حوا در داستان آفرینش دارد) منتشر شده به نام فراماشین یا (Ex Machina). ربات انساننمای این فیلم، «ایوا»(Ava)، از هوش مصنوعی پیشرفته خود برای تحلیل روانشناختی شخصیت اصلی (کیلب) استفاده میکند. ایوا با درک عمیق از تنهایی، امیال و ضعفهای کیلب، او را بهطور کامل دستکاری میکند تا به هدف خود یعنی فرار دست یابد. این فیلم نمونهای عالی از چگونگی استفاده از هوش و تحلیل داده برای بازی با احساسات و تصمیمات یک انسان است.

بازتولید تعصبات اجتماعی

الگوریتمهای هوش مصنوعی براساس دادههایی آموزش میبینند که از دنیای واقعی استخراج شدهاند؛ دنیایی که پر از تعصبات نژادی، جنسیتی و طبقاتی است. در نتیجه سیستمها نه فقط این تعصبات را یاد میگیرند، بلکه آنها را در مقیاسی بزرگ بازتولید و تقویت میکنند. برای مثال یک الگوریتم تولید محتوا ممکن است کلیشههای جنسیتی را ترویج دهد یا یک سیستم تعدیل محتوا، صدای گروههای اقلیت را بیشتر از گروههای اکثریت سرکوب کند. یکی از معروفترین فیلمهایی که درباره هوش مصنوعی ساخته شده و با استقبال مخاطبان نیز همراه شده فیلم او یا (Her) است. گرچه این فیلم جنبههای رمانتیک هوش مصنوعی را بررسی میکند اما میتوان آن را از این زاویه نیز تحلیل کرد. سیستمعامل «سامانتا» برای درک و ارتباط با انسانها، کل اینترنت و تولیدات فرهنگی بشر را پردازش میکند. اگر این دادهها حاوی تعصبات باشند (که هستند)، هوش مصنوعی نیز ناگزیر آن تعصبات را در تعاملات و پیشنهادهای خود بازتاب خواهد داد و بهطور نامحسوس به عادیسازی آنها کمک میکند.

فرسایش اعتماد به نهادها و واقعیت مشترک

وقتی شهروندان نتوانند تشخیص دهند که کدام خبر واقعی و کدام جعلی است، یا احساس کنند که دائما تحت دستکاری الگوریتمها هستند، اعتماد خود را به رسانهها، دولت، علم و حتی خود مفهوم حقیقت از دست میدهند. این «اقتدارزدایی معرفتی» جامعه را به سمت هرجومرج و پوچگرایی سوق میدهد و هرگونه اجماع برای حل مشکلات بزرگ اجتماعی را غیرممکن میسازد. یکی از فیلمهایی که بهخوبی قدرت رسانه برای مهندسی افکارعمومی را به نمایش میگذارد فیلم به بالا نگاه نکن یا(Don’t Look up) است. این فیلم کمدی سیاه بهخوبی نشان میدهد که چگونه در یک فضای رسانهای اشباعشده و الگوریتممحور، یک حقیقت علمی آشکار (برخورد یک شهابسنگ به زمین) به یک موضوع قابل بحث و نظر شخصی تبدیل میشود. تلاش دانشمندان برای هشدار به مردم در میان موجی از اطلاعات نادرست، تئوریهای توطئه و محتوای سرگرمکننده تولید شده برای افزایش بازدید، گم میشود. این فیلم استعارهای قدرتمند از فرسایش واقعیت مشترک است.